Beim dritten AI for Media Network Meetup beleuchteten wir das Thema „KI-Agenten“ aus verschiedenen Perspektiven: Was fällt alles unter den Begriff KI-Agent, wann lohnt sich der Einsatz für Redaktionen und wann nicht. Es gab eine sehr praxisnahe Demo zur Nachrichtenproduktion mit Agenten, aber auch ein paar kritische Worte zum Hype um die Agenten durften nicht fehlen.

Mehr als 140 Interessierte waren der Einladung zum dritten AI for Media Meetup bei Ippen Digital gefolgt. Der neue Besucher*innen-Rekord zeigt, dass wir mit dem Thema „KI-Agenten im Newsroom“ den richtigen Nerv getroffen hatten.

Die Definition von KI-Agenten ist nicht einfach, es kursieren verschiedene Vorstellungen, wie Sam Gould, AI Lead bei FT Strategies erklärte. Immer eine Rolle spielen aber Sprachmodelle, die für die User*innen eine Aufgabe erfüllen. Dabei gibt es mehrere Abstufungen, wie eigenständig Agenten das machen, auf welche Datenbanken und Werkzeuge sie dabei zugreifen können und wie oft der Mensch die (Zwischen-)Resultate kontrolliert. Im journalistischen Kontext werden KI-Agenten häufig als Bestandteil von automatisierten Workflows verwendet: Eine Aufgabe wird in mehrere Teilschritte zerlegt, bei deren Erfüllung Agenten – in diesem Kontext sind Sprachmodelle gemeint – zum Einsatz kommen.

In diesem Video erklären KI-Experten von Ippen Media und Uli Köppen, Chief AI Officer des Bayerischen Rundfunks (BR), wie KI-Agenten funktionieren:

BR Use Case: Nachrichteninhalte mit Agenten in Videotext-Meldung umwandeln

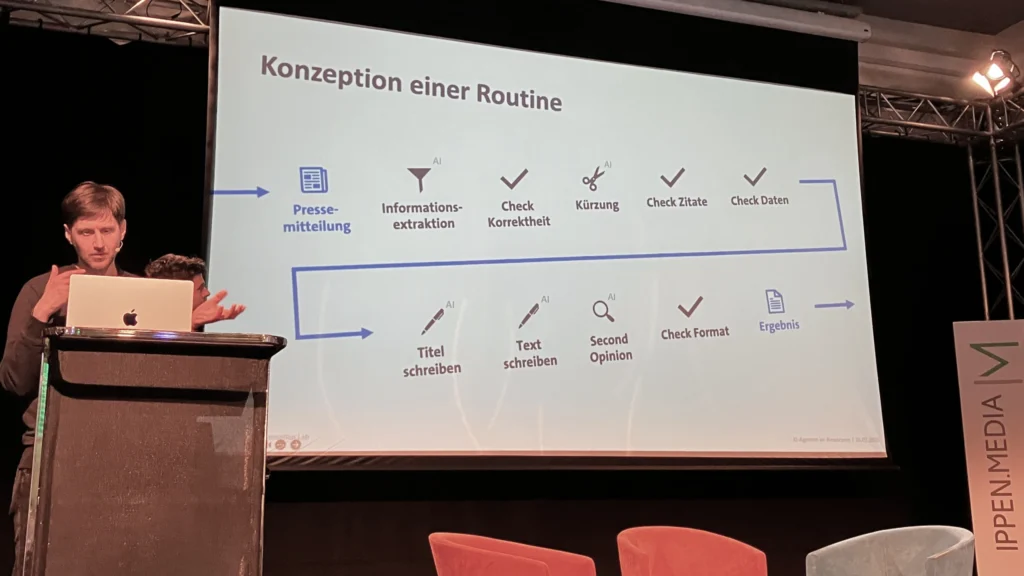

Sebastian Bayerl und Philipp Gawlik, zwei Entwickler aus dem AI + Automation Lab des BR, demonstrierten einen Use Case, in dem ein KI-Agent bei der Nachrichtenproduktion zum Einsatz kommt: Eine Agenturmeldung oder ein Korrespondentenbericht soll so redigiert werden, dass er im BR-Videotext veröffentlicht werden kann. Diesen Prozess hat das Team in neun Teilschritte unterteilt – in den meisten davon kommen Sprachmodelle zum Einsatz (z. B. zur Informationsextraktion, Kürzung, Textgenerierung oder Inhaltskontrolle). Die Journalist*innen steuern die Agenten bzw. Sprachmodelle über möglichst präzise Prompts, prüfen die Ergebnisse und nehmen bei Bedarf Korrekturen vor.

Ippen Digital demonstriert Voice Chatbot

Auch Ippen Digital verwendet bei der Artikelproduktion Agenten. In Ippens AI Publishing Studio können Redakteur*innen Workflows anlegen und Agenten Teilschritte wie die Suche von passenden Bildern und verwandten Artikeln zuweisen bis hin zum Verfassen von mehreren Artikelversionen, die aber immer einer redaktionellen Kontrolle unterliegen.

Auch in nutzerzentrierten Produkten spielen Agenten eine Rolle. Ippens CTO Markus Franz präsentierte einen Voice-Chatbot, in dem Sprachmodelle die Anfrage des Nutzenden interpretieren, in Datenbanken nach passenden Antworten suchen, eine Textantwort generieren und diese dann in natürlicher Sprache ausgeben.

Mondial plädiert für KI-Autonomität – auch bei KI-Agenten

LLM-Spezialist Sebastian Mondial kritisierte den „Hype“ um KI-Agenten und riet davon ab, Automatisierungstools der führenden US-Hersteller zu verwenden. Er plädierte für KI-Autonomität auch bei agentischen Workflows und rief Medien dazu auf, diese Workflows selbst zu bauen, zum Beispiel mit Open-Source-Tools wie Node-RED. Dieses Tool läuft auch lokal, also gelte „mein Tool, meine Regeln“.

Agenten brauchen Zugriff auf gute Daten

Sam Gould von FT Strategies gab Redaktionen ein paar Ratschläge, was sie bei der Entwicklung von KI-Agenten beachten sollten. Zunächst müsse ein klar definiertes Problem vorliegen, das mit Agenten gelöst werden könne. Der Erfolg sollte messbar sein. Für essenziell hält Gould, dass die Agenten auf qualitativ hochwertige, strukturierte Daten zugreifen können. Das können Metadaten sein oder Datenbanken, speziell Vektordatenbanken. Zum Beispiel hat die Financial Times aus ihren Artikeln eine Vektordatenbank gemacht, auf die AskFT, der RAG-Chatbot der FT zugreift, um auf Basis des darin enthaltenen Contents Antworten auf die Fragen der Nutzenden zu generieren. Außerdem empfahl Gould die besten Prompts in einer Prompt-Bibliothek zu sammeln.

Katharina Schell: Let’s not label AI – let’s label journalism

Aus einer ethischen Perspektive näherte sich Katharina Schell, stellvertretende Chefredakteurin der österreichischen Nachrichtenagentur APA dem Thema KI-generierten Texten. Schell hat im vergangenen Jahr am Reuters Institute der Universität Oxford zur Frage geforscht, wie Redaktionen Texte kennzeichnen sollen, bei deren Erstellung KI beteiligt war.

Sie betonte, dass einfache Labels kontraproduktiv sein können. Zudem lasse sich im „hybriden Journalismus“ oft gar nicht genau benennen, welchen Anteil der/die Journalist*in und welchen die KI beim Erstellen von Texten habe. Schell empfahl Redaktionen, ihren User*innen einen Einblick zu bieten, wie ihre Beiträge entstanden sind, ob – und wenn ja, welche – KI-Systeme beteiligt waren – frei nach der Devise „Let’s not label AI – let’s label journalism“.

Die Präsentationen zu den fünf Vorträgen und eine Aufzeichnung finden Sie hier (passwortgeschützt).

Whitepaper „Wie Medien im KI-Zeitalter sichtbar bleiben“ veröffentlicht

Beim Meetup wurde auch die erste Publikation des AI for Media Network vorgestellt: Das Whitepaper „Wie Medien im KI-Zeitalter sichtbar bleiben“ analysiert, wie sich die Mediennutzung im KI-Zeitalter verändert und gibt Medienhäusern Empfehlungen, was sie tun könnten, um das Publikum weiter oder sogar besser mit qualitativ hochwertigen Inhalten zu erreichen. Hier kann man es kostenlos herunterladen.

Das nächste Meetup findet am 10. Juli von 13 bis 18 Uhr beim Bayerischen Rundfunk statt.

Korrektur: In einer früheren Version des Berichts sowie in der Präsentation war fälschlicherweise von „Pressemitteilungen“ die Rede. Das BR-Team verwendet jedoch ausschließlich geprüfte Nachrichteninhalte aus der eigenen Redaktion, von Korrespondent*innen und Nachrichtenagenturen.